Le commencement des recherches

Le commencement des recherches

Cela fait déjà 22 ans que la découverte de la toute première exoplanète a eu lieu. Tout à commencé avec une campagne de recherche sur l'existence d'éventuels étoiles ayant un fonctionnement similaire au Soleil. Didier Queloz, encore thésard à l’époque, faisait partie de ces adhérents et a réussi à ouvrir les horizon vers celles-ci. En effet, c'est le 6 Octobre 1995 que Michel Mayor et Didier Queloz ont pu confirmer leur hypothèse grâce au nouveau spectrographe Élodie greffé sur le télescope de 1,93m se trouvant dans l'observatoire de Haute-Provence et au logiciel très performant qu'ils avaient co-écrit au préalable. Il n'avait cependant pas pour intention première de trouver une planète à contrario, de leur collègue Geoffrey Marcy. Très investis dans cette quête depuis plusieurs années, les deux chercheurs, et toute l'équipe technique ayant contribué à cette réussite, ont alors devancé les autres scientifiques en publiant leurs résultats le 23 novembre 1995 dans Nature une revue scientifique généraliste de référence, à comité de lecture et publiée de manière hebdomadaire, est également l'une des revues scientifiques les plus anciennes et les plus réputées au monde. Mais comment s'est déroulée cette découverte ?

Avec les avancées technologiques, de nouvelles exoplanètes sont découvertes tous les jours. Pour répondre à la question posée précédemment, nous ferons la rencontre détaillée des deux chercheurs, Didier Queloz et Michel Mayor. Ensuite, nous étudierons les découvertes faites avant 1995. Enfin, nous terminerons par analyser les recherches pratiquées après 1995.

A) FICHE TECHNIQUE : Qui sont Didier Queloz, Michel Mayor et 51 Pegasi b ?

Cela faisait des mois qu'ils s'évertuaient à garder le secret, depuis qu'ils avaient acquis la quasi-certitude durant l'été 1995, après de nombreuses vérifications, que leurs mesures de vitesse radiale* de l'étoile 51 Pegasi trahissaient bien la présence d'un astre en orbite autour d'elle. Il ne s'agissait pas d'une naine brune mais d'une exoplanète deux fois moins massive et 1,6 fois plus grande que notre Jupiter, qui fut nommée 51 Pegasi b. Pour la première fois, des astronomes apportaient la preuve que des planètes gravitent autour d'autres étoiles que la nôtre. Certes, nous nous doutions déjà qu'avec l'infinité de l'univers, il n'existait pas qu'un seul Système solaire dans la Galaxie, mais rien n'était encore prouvé !

Cependant la tâche semblait encore fastidieuse à l'époque, car les théories prévoyaient que les grosses planètes comme Jupiter, les plus faciles à détecter, ne mettaient pas moins de 10 ou 11 ans pour faire le tour de leur étoile, ce qui bien évidemment ne laissait pas une très grande marge d'observation aux scientifiques.

Pour cette raison, nombreux ont été les collègues ayant engagé des recherches sur plusieurs années qui accueillirent avec méfiance et scepticisme la découverte de 51 Pegasi b. Deux scientifiques, Michel Mayor et Didier Queloz, essuyèrent même de vives critiques des mois durant. Quant à Geoffrey Marcy, il admit rapidement l'existence de cette exoplanète qui n'était pas à l'endroit attendu et qui n'avait pas l'apparence supposée, et félicita les deux chercheurs. Ce n'est que quelques années plus tard que son existence fut approuvée et que d'autres géantes furent mises en évidence.

DIDIER QUELOZ MICHEL MAYOR

Voici quelques détails sur nos deux chercheurs :

- Didier Queloz : de son nom complet Didier Patrick Queloz né le 23 février 1966, est un astronome suisse, professeur à l'Observatoire de Genève en Suisse et à l'Université de Cambridge en Angleterre, spécialisé dans la recherche d'exoplanètes. Il est connu notamment pour avoir découvert avec Michel Mayor 51 Pegasi b, la première planète extrasolaire confirmée comme telle et orbitant autour d'une étoile de la séquence principale.

- Michel Mayor : de son nom complet Michel G. E. Mayor, né le 12 janvier 1942, est un astrophysicien suisse. Membre de l'Observatoire de Genève et professeur honoraire à l'Université de Genève, il est, avec Didier Queloz, celui qui a découvert la première planète extrasolaire autour d'une étoile de la séquence principale, 51 Pegasi b, en 1995.

B) Avant 1995

Les grandes découvertes sur les exoplanètes n'étaient pas les plus importantes avant les années 95...Mais cela ne veut pas dire qu'elles étaient inexistantes !

a) Avant l'arrivée de l'informatique

Avant d’avoir la preuve que d’autres planètes lointaines existaient, l'avis sur la question de leur existence était très mitigé, cependant en 1970 l'observation de disques planétaires* ou protoplanétaires* a élargie la vision des scientifique. Plusieurs études décelaient même la signature indirecte d'exoplanètes ayant sculpté ces disques. Quelques planètes avaient aussi été détectées autour de pulsars (des étoiles à neutrons, vestiges de l'explosion d'étoiles massives), mais les planètes autour d'étoiles semblables au Soleil restaient cachées, à tel point que les astronomes commençaient à douter de leur existence...

Cependant, dans les années 1980, elles furent activement cherchées, bien que, techniquement, ce soit une mission très difficile, car certains instruments n’existaient pas. Les deux scientifiques à l'origine de la découverte de 1995 ont alors dû en inventer une nouvelle génération. Ils ont créé le spectrographe ELODIE, qui est devenu un prototype précurseur pour chercher des planètes.

Cependant nous pouvons remonter plus loin dans le temps pour arriver en 1917, le réexamen d’une ancienne plaque photographique révèle des indices constituant la première preuve, indirecte, de l’existence des exoplanètes, une interprétation qui était encore impossible à l’époque, car au début du 20e siècle, l'existence des exoplanètes était une théorie qui relevait plus de la science-fiction que de l'astronomie.

Effectivement, en exhumant une vieille plaque photographique en verre, datant de 1917 et sortie des collections de l'observatoire Carnegie, Jay Farihi de l'University College de Londres a fait une véritable découverte : l'image du spectre d'une naine blanche révélant la présence d'un vaste anneau de débris et de poussières, probablement issu de collisions planétaires autour d'elle. Il s'agit là de la première preuve enregistrée suggérant fortement la réalité des exoplanètes, une information impossible à interpréter en 1917. L'étoile est aujourd'hui appelé Van Maanen.

Les plaques photographiques en verre ont largement contribué aux progrès de l'astronomie du début du vingtième siècle et ce jusqu'à l'arrivée de l'informatique et des formats numériques.

La plaque photographique qui contient le spectre de l'étoile de van Maanen représentée par la ligne noire

centrale. En agrandi, les deux lignes d'absorption.

b) Un peu d'histoire...

Tout ceci montre que la plus grande lacune n'était pas la technique, mais plutôt l'étendue de connaissance des scientifique de l'époque qui n'étaient pas encore assez étoffée pour émettre cette interprétation. Pourtant des esprits du passé avait depuis longtemps déjà émis cette hypothèse, qu'elle soit fondée ou non.

Dès l’Antiquité, dans sa Lettre à Hérodote, Epicure expose sa vision de l’existence d’une infinité de mondes :

« Ce n’est pas seulement le nombre des atomes, c’est celui des mondes qui est infini dans l’Univers. Il y a un nombre infini de mondes semblables au nôtre et un nombre infini de mondes différents. »

Bien plus tard, au XVIe siècle, le philosophe italien Giordano Bruno, s’appuyant sur l’héliocentrisme* de Copernic, est le premier à affirmer, sans démonstration physique mais d’un point de vue philosophique, que :

« Il est donc d’innombrables soleils et un nombre infini de terres tournant autour de ces soleils, à l’instar des sept « terres » que nous voyons tourner autour du Soleil qui nous est proche. » (Giordano Bruno, L’Infini, l’Univers et les Mondes, 1584).

Le Néerlandais Huyghens, mathématicien, physicien et astronome, est le premier à penser utiliser les instruments d’observation, alors en plein développement, pour observer des planètes lointaines. Il est à l'origine de la découverte des anneaux de Saturne et de son principal satellite, Titan, en 1655.

C'est la naissance d’une nouvelle discipline scientifique, la planétologie, au XIXe siècle, conjointement à la mise au point d’instruments de mesure et d’observation de plus en plus puissants, qui vont permettre de nombreuses avancées dans la connaissance de l’Univers. Plus proche de nous, l’astronome américain Edwin Hubble, à l’origine du concept d’expansion de l’Univers, déclare en 1924 :

« La communauté scientifique suppose depuis longtemps que si les étoiles sont des soleils, et que le Soleil héberge des planètes, alors il est fort probable que les autres étoiles hébergent elles aussi des planètes. »

L'origine de cette ambition qu'est la découverte d'exoplanètes, date donc de l'Antiquité.

A) Après 1995

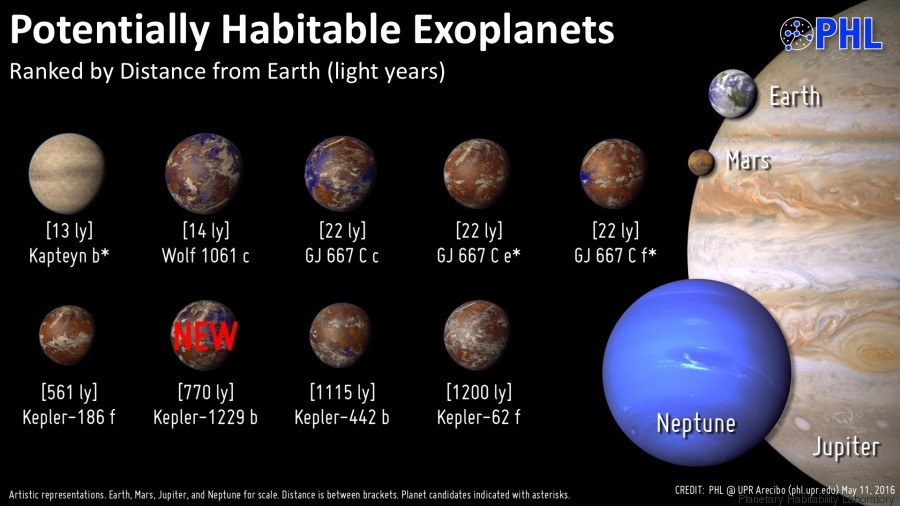

La recherche d'exoplanètes s'est intensifiée après la découverte de 1995, conduisant à la détection de plus de 350 nouvelles planètes, la plupart étant des géantes gazeuses. Depuis peu, ils ont découvert des planètes plus légères et telluriques, c'est-à-dire ayant une surface solide.

En outre, alors qu'elle s'est focalisée pendant longtemps sur les alentours des étoiles de type solaire, cette recherche s'est ouverte récemment à d'autres classes d'étoiles, plus ou moins jeunes et plus ou moins massives, les étoiles les plus légères étant les plus nombreuses dans notre galaxie. On peut ainsi étudier l'influence de l'âge et de la masse de l'étoile centrale sur la formation des systèmes planétaires.

En 1999, des astronomes déterminaient pour la première fois le rayon d'une exoplanète, hd209458 b, par la méthode dite des "transits. Le couplage avec les données vélocimétriques a aussi permis d'établir la masse exacte de la planète. Depuis, une soixantaine de transits d'exoplanètes ont été observés. Grâce à ces nouvelles mesures, les scientifiques commencent à percer les intérieurs planétaires ainsi que la composition chimique de leur atmosphère.

Depuis 2005, des méthodes d'imagerie permettent de visualiser l'apparence de certaines exoplanètes. Le premier corps « imagé » de masse planétaire, c'est-à-dire de masse inférieure à 13 fois celle de Jupiter, tourne autour d'une naine brune, un astre trop petit pour enclencher des réactions nucléaires de fusion de l'hydrogène, à une distance comparable à celle qui sépare Pluton du Soleil. Depuis, une dizaine d'autres exoplanètes ont pu être « imagées », orbitant à des distances variables autour de véritables étoiles.

Ces découvertes, toujours plus nombreuses, ont révélé une diversité insoupçonnée jusqu'alors, et qu'il faut, bien sûr, expliquer. Ainsi en prenant de l'ampleur ces découvertes ont mené à des ambitions plus grandes telle que l'éventuelle existence d'une exoterre.

*VOCABULAIRE*

* Vitesse Radiale : La vitesse radiale est la vitesse d'un objet mesurée dans la direction du rayon (ou la ligne de visée) vers ou depuis le point d'observation.

* Disque planétaire ou protoplanétaire : Un disque protoplanétaire est un disque circumstellaire* constitué de gaz et de poussières à partir duquel se forment les corps (planètes, planètes naines, petits corps et leurs satellites)

* Circumstellaire : qui tourne autour d'une étoile

* Héliocentrisme : système astronomique d'après lequel on considère le Soleil comme le centre de l'Univers (astronomie ancienne) ou comme l'astre autour duquel s'effectue la rotation des planètes (s'oppose à géocentrisme)

Les avancées technologiques et scientifiques

Les avancées technologiques et scientifiques

Avec les nouvelles découvertes faites dans l'espace concernant la vie possible sur d'autres planètes, les chercheurs et astrophysiciens ne cessent de lancer de nouveaux objectifs. Grâce à sa curiosité, l'être humain est capable d'avancer et de se passionner pour tout ce qui lui est inconnu. C'est ainsi que nous fonctionnons : lorsque nous trouvons des réponses à des questions parfois "vieilles comme le monde", il n'est pas question de s'arrêter là. A quelle température l'eau peut-elle passer de l'état liquide à l'état solide ? A 0°C, me répondrez-vous...Oui, mais pourquoi se solidifie-t-elle ? C'est sur ce modèle de "une question entraîne une réponse qui entraîne une autre question" que l'être humain a choisi de se baser pour en apprendre toujours plus...Mais, au niveau de l'astrophysique, comment les scientifiques avancent-ils avec leurs découvertes ?

Avec les nouvelles technologies, comme les bases spatiales, les satellites artificielles ou encore les sondes, l'être humain a pu non seulement étudier le vide intersidérale de l'espace, mais est également parvenu à s'y rendre. Thomas Pesquet, par exemple, est un astronaute français de l'ESA (ou "Agence Spatiale Européenne") envoyé le 17 Novembre 2017 vers la Station Spatiale Internationale. Il a alors passé 196 jours à bord, avant de la quitter le 2 Juin 2017. Cette expédition nous montre à quel point l'être humain est capable de s'aventurer pour pouvoir mener à bien ses projets de découverte. Tout d'abord, nous définirons et exprimerons l'équation de Sara Seager dans une fiche détaillée, puis nous étudierons les différentes intelligences artificielles avant de nous intéresser à la miniaturisation des satellites.

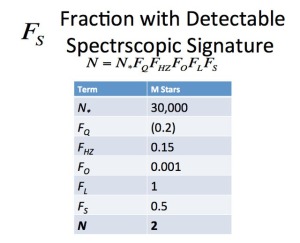

A) FICHE TECHNIQUE : Qu'est-ce que l'équation de Sara Seager ?

Sara Seager est une astronome et planétologue canado-américaine, également professeure à l'Institute of Technology du Massachussetts. Spécialisée dans l'étude des exoplanètes et tout particulièrement de leur atmosphère, elle a écrit de nombreux ouvrages et s'est vue attribuer un prix MacArthur en 2013. Elle développa une équation modifiée de l'équation de Drake, célèbre proposition mathématique concernant certaines branches scientifiques : il s'agit d'un calcul permettant plus précisément de trouver les planètes où la vie pourrait évoluer.

Sara Seager

Cette formule permet de chercher le nombre de planètes ayant une signature gazeuse anormale et pouvant être détectées dans une dizaine d'années. Or, si une planète possède un gaz qui ne devrait pas y être naturellement, c'est qu'une forme de vie le produit probablement. Par exemple, sans la vie sur Terre, il n'y aurait presque pas d'oxygène dans l'atmosphère...

Cette équation alors, quelle est-elle ?

L'équation de Sara Seager est :

avec 7 variables :

- N : il s'agit du nombre de planètes ayant une signature gazeuse anormale

- N* : il s'agit du nombre d'étoiles prises en compte dans le calcul

- FQ : il s'agit de la fraction d'étoiles dites "calmes", s'opposant ainsi aux étoiles ayant une activité météorologique ou gazeuse trop importante, ce qui rend la présence de vie impossible...

- FHz : il s'agit de la fraction de planètes rocheuses dans la zone habitable du système étudié

- Fo : il s'agit du nombre de systèmes observables

- FL : il s'agit de la fraction de planètes avec une forme de vie connue, c'est-à-dire la Terre

- FS : il s'agit de la fraction de planètes ayant une signature spectroscopique détectable, pour lesquelles il est possible d'observer la composition gazeuse

Cette équation est peut-être la nouvelle clé mathématique concernant la quête d'une vie extraterrestre ! Ainsi, puisqu'il comporte sept variables, dont la valeur peut évidemment différer avec le temps et selon les scientifiques l'utilisant, ce calcul n'est pas totalement fiable. Sara Saeger elle-même se donne une marge d'erreur. Par exemple, N* et Fo sont deux termes de l'équation que évolueront avec les avancées technologiques. Cependant, pour le moment, d'après les calculs de l'astronome, il est probable que l'on découvre deux planètes ayant une signature gazeuse anormale d'ici les dix prochaines années.

Tableau des valeurs actuelles des variables de l'équation

Cette équation se nourrit donc des avancées scientifiques de notre époque.

B) Les intelligences artificielles

L'intelligence artificielle, souvent notée IA, est considérée comme l'ensemble des théories et des techniques mises en œuvre en vue de réaliser des machines capables de "simuler" l'intelligence. C'est donc un ensemble de concepts et de technologies, et non pas une discipline autonome constituée.

a) La lentille gravitationnelle

Une étude rapporte que les réseaux de neurones peuvent analyser les distorsions complexes de l'espace-temps que l'on nomme "lentilles gravitationnelles". C'est un terme de l'astrophysique désignant en réalité un mirage gravitationnelle produit par la présence d'un corps céleste massif, comme un amas de galaxies, se situant entre un observateur et une source lumineuse assez lointaine.

En imprimant un fort champ gravitationnel autour d'elle, la lentille fera dévier les rayons lumineux à proximité, et déformera donc les images reçues par un observateur placé sur la ligne de visée. Un champ gravitationnel est réparti dans l'espace, il est dû à la présence d'une masse susceptible d'exercé une influence gravitationnelle sur un autre corps proche. Si nous sommes dans un cas où l'alignement de la source observée et du corps céleste (qui joue le rôle de la lentille gravitationnelle) par rapport à l'observateur, le mirage peut prendre la forme de ce que l'on appelle un "anneau d'Einstein". Qu'est-ce donc que cet anneau ? Il s'agit en réalité du résultat de la déformation d'une source lumineuse passant à travers une lentille gravitationnelle formée par un corps céleste extrêmement massif, comme, par exemple, une galaxie ou un trou noir. Cette déformation prend alors la forme d'un anneau, d'où le nom. Pour que ce phénomène, nommé en l'honneur d'Albert Einstein, bien sûr, qui est à l'origine de l'existence des lentilles gravitationnelles grâce à sa théorie de la relativité générale, soit visible, il faut que l'observateur, la lentille et la source soient parfaitement alignés, mais aussi que l'observateur soit assez proche du point où l'image de l'objet se forme. La taille de l'anneau d'Einstein est ainsi donnée en radian.

avec :

la taille angulaire en radian

la taille angulaire en radian la constante gravitationnelle

la constante gravitationnelle la masse de la lentille

la masse de la lentille la vitesse de la lumière, soit 3,0 x 108 m/s

la vitesse de la lumière, soit 3,0 x 108 m/s la distance angulaire de la lentille

la distance angulaire de la lentille la distance angulaire de la source

la distance angulaire de la source la distance angulaire entre la lentille et la source

la distance angulaire entre la lentille et la sourceDe plus, la constante gravitationnelle se calcule ainsi :

Plusieurs mirages gravitationnels ont pu être observé depuis la mise en avant de la relativité générale par Einstein, notamment grâce au télescope spatial Hubble. Ils sont particulièrement présents lorsque nous faisons des clichés de champs profonds de l'univers observables. Leurs effets peuvent même servir à détecter de la matière noire présente dans l'Univers. La matière noire est une catégorie de matière hypothétique permettant de rendre compte d'observations astrophysiques, comme les estimations de la masse des galaxies. Elle serait composée de gaz moléculaires, d'étoiles mortes, de npmbreuses naines brunes, de trous noirs...La matière noire pourrait avoir une abondance jusqu'à cinq fois supérieure à celle de la matière baryonique, constituant environ 27% de la densité d'énergie totale de l'Univers observable !

Il existe trois catégories de lentilles gravitationnelles, qui sont :

- les lentilles gravitationnelles fortes : elles peuvent produite des images multiples et même des anneaux d'Einstein

- les lentilles gravitationnelles faibles : elles sont plus difficiles à observer que les lentilles gravitationnelles fortes peuvent être produites par des corps célestes de masse plus ou moins grande

- les microlentilles : elles permet d'étudier les objets qui émettent peu, voire pas du tout de lumière.

Imaginons maintenant qu'une galaxie proche et un quasar lointain se trouvent aligné sur une même ligne de visée dans la même direction du ciel par un pur hasard, un quasar étant une galaxie très énergétique avec un noyau galactique actif. La lumière provenant du quasar est alors particulièrement déviée lors de son passage près de la galaxie. Les rayons lumineux du quasar passant légèrement au-dessus de la galaxie sont donc déviés vers le bas et nous donnent à une image du quasar décalée vers le haut. A contrario, les rayons lumineux qui passent sous la galaxie sont déviés vers le haut et donnent naissance à une image du quasar décalée vers le bas. Ainsi, la galaxie proche donne naissance à plusieurs images de celui-ci en perturbant la propagation de la lumière du quasar. On détermine le nombre total d’images grâce à la forme de la galaxie et la précision de l’alignement.

De plus, après avoir multiplier les images du quasar, la galaxie va aussi concentrer ses rayons lumineux et produire des images plus brillantes. Cet effet est loin d’être négligeable pour l’astronome qui essaye d’observer des corps très peu lumineux.

Un anneau d’Einstein

b) Une exoplanète découverte par une IA

La Nasa a annoncé la découverte d'un système solaire semblable au notre en miniature autour de l'étoile Kepler-90, le 14 Décembre 2017. L'intelligence artificielle a alors permis aux astrophysiciens de découvrir une huitième exoplanète dans ce système solaire, qui devient alors le premier système à compter le même nombre de planètes que celles en orbite autour de notre Soleil ! Cette exoplanète rocheuse est baptisée Kepler-90i, et elle est située à 2545 années-lumière de la Terre...un sacré bout de chemin à parcourir, quand même !

Kepler-90i, environ 30% plus grande que la planète Terre, a été détectée il y a peu, mais est déjà classée dans les planètes inhospitalière, avec une température moyenne de 426°C à sa surface, comme sur Mercure. En effet, elle est beaucoup trop proche de son étoile, dont elle fait le tour en 14,4 jours...Cependant, une autre planète du même système solaire, Kepler-90h, se trouve à la même distance de son étoile Kepler que la Terre du Soleil, d'après la Nasa.. Le système stellaire Kepler-90 est une version miniaturisée de notre système solaire à nous, avec de petites planètes proches de leur étoile qui, en s'éloignant, deviennent de plus en plus grosses. Elles sont cependant beaucoup plus resserrées que dans notre système. Du moins, c'est ce qu'explique Andrew Vanderburg de l'université du Texas à Austin.

La question que nous nous posons alors est : comment l'intelligence artificielle, ou "réseau neuronal", a-t-elle permis cette découverte incroyable aux yeux des astrophysiciens ? En effet, cette expérience montre que l'intelligence artificielle, en plus d'être un outil moderne, est extrêmement prometteuse pour trouver des signaux plus faibles, notamment des signaux de planètes lointaines. Ainsi, une machine à apprendre de Google a enseigné à un ordinateur à scanner 35 000 signaux d'exoplanètes potentielles captés par le télescope américain Kepler quand une planète passait devant son étoile. Lorsque cet événement se produisait, on pouvait observer une baisse de luminosité de l'étoile. Cette approche a déjà permis de découvrir 2 500 exoplanètes...

Vue d'artiste du télescope Kepler

Dernièrement, le 2 Février 2018, la Nasa a annoncé une découverte incroyable : les sept planètes du système Trappist-1 sont, comme la Terre, des planètes rocheuses possédant une atmosphère pauvre en hydrogène (un gaz néfaste au développement de la vie) et qui pourraient probablement abriter de grandes quantités d'eau et donc, théoriquement, de la vie ! L'étoile Trappist-1a est une naine rouge "super froide" située à 39 années-lumières de la Terre et découverte en 2005.

Illustration de la Nasa comparant le système solaire au système Trappist-1

L'avancée technologique et scientifique est en marche, de nouvelles découvertes ne cessent de se faire tous les jours. Grâce à cette nouvelle technique d'intelligence artificielle imitant la structure du cerveau humain en pouvant classer les informations et apprendre le nombre de découvertes qui devraient encore augmenter d'après les scientifiques. Ils prévoient alors d'appliquer cette incroyable approche au 150 000 étoiles environ scrutées par Kepler pendant quatre ans.

C) La miniaturisation des satellites

La miniaturisation des satellites consiste à réduire la masse des satellites artificielles et des sondes spatiales, afin de permettre l'abaissement des coûts de lancements et la diminution de l'énergie consommée.

a) Comment est-ce possible

Comparé à un gros satellite commercial, un nanosatellite est un satellite de petite taille, qui permet de tester à bas coût et rapidement de nouvelles technologies dans l’espace et de collecter des données (observation environnementale…). Une fois la technologie validée dans l’espace, elle pourrait être développée pour les gros satellites, sans risque. Comme pour les téléphones portables, la miniaturisation liée à l’évolution de la technologie va permettre de développer des applications de plus en plus performantes.

- La plateforme : L’ensemble des éléments qui permettent au nanosatellite de fonctionner : la structure mécanique, l’ordinateur de bord « OBC » (le cerveau du nanosatellite), le système de production et stockage d’énergie « EPS » (panneaux solaires, batterie, carte de gestion…), un système de télécommunication (antennes, émetteur / récepteur…). Certains CubeSats, et en particulier les 3Unités, sont aussi équipés d’un contrôle d’attitude, qui permet de les orienter dans l’espace.

- La charge utile, ou l'expérience : Equipement placé à l’intérieur de la plateforme, spécifique à chaque mission et qui va réaliser l’expérience (test de tolérance aux radiations, transfert de données, observation …).

- Survie : L’espace est un environnement hostile. Le nanosatellite doit y survivre durant toute la durée de la mission. Après avoir subi de très fortes vibrations au décollage de la fusée, il doit aussi résister à des températures très élevées face au soleil, au très grand froid à l’ombre, aux radiations extrêmement agressives de l’espace, avec les contraintes du vide de l’espace, qui empêchent les échanges thermiques par convection et qui produisent des dégazages.

- Développement durable : Sa mission terminée, ou en cas de défaillance, il ne doit pas constituer un débris qui puisse endommager les autres satellites ou polluer l’espace. Il faut donc le faire redescendre vers la Terre et se consumer en rentrant dans l’atmosphère. Tous nos nanosatellites sont compatibles avec la loi L.O.S. relative aux opérations spatiales, qui garantie notamment cet aspect de développement durable.

Prenons pour exemple le nanosatellite Dove de la société Planet, ce nanosat de 10*10*30cm possède un poids d’environ 5kg stabilisé sur 3 axes et ne dispose d’aucune source de propulsion. Sa charge utile se limite à un dispositif optique composé d’une caméra CCD offrant une résolution spatiale comprise entre 3 et 5 mètres. Chaque satellite Dove permet de collecter 2 millions de kilomètres carrés par jour et le satellite complète une orbite en environ 90 minutes. A titre de comparaison, ces petits satellites de quelques kilos seulement offrent aujourd’hui des résolutions d’image bien supérieures au satellite SPOT lancé en 1986 qui pesaient alors 1,7 tonnes.

La réduction de la taille des satellites permet à la fois de rationaliser les coûts de production mais surtout de mise en orbite grâce à un poids bien inférieur à celui des satellites d’observation traditionnels.

b) Les nanosatellites, nouvelles stars de l'espace

Depuis quelques années, l’émergence de nouveaux acteurs commerciaux chamboule le monde de l’observation spatiale et semble donner un nouvel élan à ce marché qui, autrefois réservé aux institutions, se démocratise de plus en plus. L’essor des technologies et plus particulièrement de la miniaturisation des satellites permettent à ces nouvelles entreprises de réduire drastiquement les coûts et de mettre en orbite de véritables constellations de satellites.

La résolution d’image n’est plus le seul argument avancé par les opérateurs, le nombre de satellites qui composent ces constellations permet aujourd’hui des taux de revisite encore inédits et contribue à la mutation des modèles de fourniture d’image traditionnels. Estimé à 3,5 milliards de dollars par Euroconsult, le marché de l’observation spatiale bénéficie d’une croissance annuelle très élevée qui attire de nombreux investisseurs. « Nous croyons qu’il y aura un moment unique où cette industrie va être similaire à ce qui s’est passé, par exemple, dans la navigation », a déclaré Wade Larson, président et chef de la direction d’Urthecast à Vancouver.

Aujourd’hui, la bataille fait rage entre les différents acteurs de l’observation spatiale qui adaptent leur stratégie pour proposer une imagerie abondante et bon marché. La quantité de données générées par ces nouvelles constellations pousse la sphère privée à se tourner vers de nouvelles solutions automatisées, faisant notamment appel à l’intelligence artificielle, pour proposer des services et débouchés commerciaux innovants. La maîtrise du cycle de vie de l’image, de sa collecte à sa valorisation, de son mode de diffusion semble être aujourd’hui la clef du succès pour démocratiser l’imagerie spatiale au plus grand nombre.

Pour créer ces nanosatellites, certains de ces nouveaux acteurs ont littéralement pris le contre-pied de l’industrie spatiale traditionnelle en utilisant des techniques de fabrication modernes et industrielles, ainsi que des méthodes de l’électronique grand public pour concevoir les satellites et leurs systèmes de contrôle de mission (X. Pasco 2017). Cette nouvelle approche permet de produire des satellites en série et d’optimiser les coûts comme de faire évoluer rapidement les générations de matériels.

L’exemple des satellites de l’ancienne société Skybox est également intéressant, pour un volume plus proche de celui d’un mini-frigo et un poids d’environ 100kg, les SkySat offrent une résolution proche du mètre, secondé par la capacité de capturer de courtes vidéos (de 30 à 90 secondes). Récemment acquis par la société Planet, ces satellites viennent compléter la constellation de satellites de la startup pour compléter son offre avec des images de haute résolution.

Le faible coût d’infrastructure de ces projets incite des investisseurs privés non issus du secteur spatial à investir dans ce secteur prometteur. Le rachat par Google de la société Skybox en 2014 (rebaptisée par la suite Terra Bella puis revendu à Planet en 2017) est l’illustration parfaite de cette tendance.

Les conditions de vie sur Terre

Les conditions de vie sur Terre

La vie est capable de prospérer sur Terre dans des endroits très surprenants : certaines espèces sous-marines sont ainsi capables de survivre à des profondeurs si extrêmes que l'Homme n'a pas encore percé tous leurs mystères. L'un des exemples les plus incroyables est le tardigrade : cet animal invertébré aux capacités extraordinaires ne mesure qu'entre 0,1 et 1,5 mm ! Il est pourtant capable de supporter des températures extrêmes (-272,8 °C, soit quasiment le zéro absolu) et des pressions importantes (jusqu'à 1200 atmosphères !), mais également de survivre à des doses de radiations extraordinaires (jusqu'à 570 000 rads, alors que 500 suffisent à tuer un humain) : de quoi qualifier les super-héros de "petites natures" ! Les scientifiques sont amenés à penser que le tardigrade serait d'origine extraterrestre...Mais alors, est-ce que cela signifie que la vie est capable de se développer partout dans l'Univers ? La réponse est évidemment non.

La vie est capricieuse, c'est une de ses premières caractéristiques que les scientifiques ont eu le "plaisir" de constater...Pour qu'elle puisse apparaître sur une planète, il faut que cette dernière se plie à des règles très spécifiques. Ces règles, ou conditions, sont celles d'un équilibre : la taille de cette planète, son poids, son champ magnétique, son atmosphère...tous ces détails sont primordiaux pour que la vie puisse faire son apparition. Nous allons tout d'abord nous concentrer sur les conditions de vie sur une planète à l'aide d'une fiche technique détaillée, puis nous nous intéresserons aux caractéristiques physiques d'une planète avant de terminer par une les caractéristiques chimiques qui ont retenus l'attention des scientifiques quant au développement de la vie à sa surface.

A) FICHE TECHNIQUE : Quelles sont les conditions qui peuvent amener à la vie sur une planète ?

La vie est capable de se maintenir partout où elle peut disposer d'eau et d'une source d'énergie : certaines moisissures vivent ainsi sur une roche et s'en nourrissent. Mais pour apparaître sur une planète, il faut que la plupart des conditions de vie soient réunies pour qu'elle puisse s'y développer...

- Sur le plan galactique : elle doit se trouver assez proche du centre galactique afin que des minéraux puissent se former après la mort de certaines étoiles, mais aussi assez loin pour éviter les explosions de supernovae, les radiations extrêmes ou encore l'attraction des trous noirs galactiques

- Sur le plan de son système : elle ne doit pas être située trop proche de son étoile, au risque de ne pas avoir d'eau liquide à sa surface

- Sur le plan de sa taille et de son axe de rotation : elle ne doit être ni trop grosse, ni trop petite

- Sur le plan de son voisinage : il est préférable qu'elle est une voisine de très grosse taille (semblable à celle de notre Jupiter), afin d'empêcher les comètes et les astéroïdes de s'écraser à sa surface grâce à un puissant pouvoir d'attraction

- Sur le plan de son champ magnétique : elle doit posséder un champ magnétique qui la protégera des radiations solaires et des rayons cosmiques mortels pour les formes de vie

- Sur le plan atmosphérique : elle doit avoir une atmosphère qui la protégera des rayons cosmiques mortels

- Sur le plan géologique : elle doit sans cesse pouvoir renouveler les molécules de gaz carbonique de son atmosphère pour assurer la présence d'eau liquide

Ainsi, si ces conditions sont respectées, et si de gigantesques astéroïdes ne décident pas de venir tout détruire en s'écrasant à sa surface, la vie pourra peut-être se développer sur cette planète...

B) Les caractéristiques physiques particulières d'une planète

La physique est une branche de la science qui s'intéresse à la "connaissance de la nature" (du latin "physica" qui signifie "science de la nature"). Les caractéristiques physiques d'une planète sont donc liées aux mécanismes naturels de celle-ci. Nous allons nous intéresser à deux d'entre elles : la distance entre une planète et son étoile dans un même système planétaire, puis la masse de cette étoile et de la planète elle-même.

a) La distance par rapport à son étoile

La distance entre une planète et son étoile permet aux astrophysiciens de déterminer la quantité reçue par la planète de rayonnement solaire, conditionnant ainsi trois facteurs primordiaux à l'apparition de la vie : la température, la lumière disponible et la quantité reçue de rayonnements nocifs. Mais comment peut-on donc calculer cette distance ? Par quelle formule est-il possible d'étudier l'espace séparant une planète, telle que notre Terre, à son étoile, comme le Soleil ?

Pour cela, nous allons devoir remonter bien des années auparavant, dans l'Antiquité, et plus précisément vers 289 avant Jésus-Christ. Aristarque de Samos, un astronome et mathématicien grec, se penche sur la question des distances et des dimensions du Soleil et de la Lune. En effet, il est le premier à avoir compris que les éclipses solaires étaient dues au passage de la Lune devant le Soleil, prouvant ainsi que ce dernier était plus éloigné de la Terre qu'il n'y paraissait ! Il fut également célèbre pour être l'un des premiers scientifiques à s'intéresser à la théorie de l'héliocentrisme, théorie plaçant le Soleil (et non la Terre, contrairement au géocentrisme) au centre de l'Univers.

Mais revenons à notre distance Terre-Soleil. Aristarque s'interrogea sur le moyen de la calculer avec précision. Ce fut à l'aide de méthodes mathématiques fortes ingénieuses et de beaucoup d'application qu'il parvint à obtenir un résultat...très encourageant !

Aristarque, pour calculer cette distance, choisit d'observer lorsque la lune est à "demi-pleine". On appelle cette forme le Premier Quartier de Lune. Elle se produit lorsque l'on peut voir seulement la moitié de la Lune éclairée, prouvant ainsi que l'angle formé par la Terre, la Lune et le Soleil est droit : nous appellerons cet angle TLS. Il en déduit une condition : si le Soleil était situé à l'infini, cela signifierait que le Premier Quartier serait à mis chemin entre la Nouvelle Lune et la Pleine Lune. Or, Aristarque comprend que ce n'est pas le cas, et en déduit que le Soleil est à une distance finie de la Terre. De plus, l'arc d'orbite entre le Premier Quartier et la Pleine Lune est plus long que celui entre le Premier Quartier et la Nouvelle Lune. En supposant que l'orbite de la Lune autour de la Terre est un cercle qu'elle parcours à vitesse constante, l'intervalle de temps entre la Nouvelle Lune et le Premier Quartier est le plus court. Aristarque a donc mesuré cet intervalle de temps, puis celui entre la Pleine Lune et le Premier Quartier. Il a ainsi trouvé une différence de 6 heures, et déduit un angle de 3°. A l'aide d'équation lui permettant de résoudre le triangle TLS, il affirme que le Soleil est 19 fois plus loin que la Lune de la Terre.

Schéma de l'expérience d'Aristarque

Les triangles TLS et HTS sont respectivement rectangles en L et en H.

- (LT) ⊥ (LS)

- (HT) ⊥ (ST)

sin(LST) = LT / ST

D'où :

ST = LT / sin(LST)

Grâce au calcul de l'angle LST, la distance Terre est obtenue en fonction de la distance LT.

Cependant, Aristarque commis une erreur dans son raisonnement. En effet, en observant seulement à l'œil nu, la mesure du temps ne peut pas être précise : ce n'est donc pas une valeur de 6 heures qu'il est censé trouver, mais une valeur de 35 minutes. Ainsi, le Soleil n'est pas 20, mais 387 fois plus éloigné que la Lune de la Terre : Aristarque s'est donc trompé d'un facteur de 20 environ ! Cette méthode reste cependant forte ingénieuse, et nous permettait déjà de comprendre que le Soleil se trouvait beaucoup plus loin de la Terre que la Lune.

Il existe, évidemment, de nouvelles méthodes pour les calculer. De plus, il faut comprendre que la Terre n'est pas toujours située à la même distance du Soleil suivant sa position : c'est également le cas des autres planètes du système solaire. Il s'agit donc toujours de mesures approximatives et instables.

Nous avons vu que la distance séparant une planète de son étoile déterminait la quantité reçue de rayonnement solaire. Elle conditionne donc :

- la température : la température détermine la présence ou non d'eau liquide à la surface de la planète, ce qui est indispensable pour le développement de la vie

- la lumière : les végétaux ont besoin de lumière pour se développer

- la quantité de rayonnements nocifs : certains rayonnements solaires, tels que les rayons ultra-violets et les rayon gamma, sont néfastes pour le développement de la vie et la stabilité de l'ADN sur une planète.

Ainsi, si la Terre avait été plus proche du Soleil de seulement 4%, sa destinée aurait été celle de Vénus, celle d'une véritable fournaise, tandis que si elle avait été éloignée de 1 ou 2%, son sort aurait été celui de Mars, la planète glacée : on peut en déduire que la bande d'espace favorable à la vie autour d'une étoile est relativement étroite.

b) Sa masse et celle de son étoile

La masse d'une planète permet aux scientifiques de déterminer la composition de leur atmosphère, tandis que la masse de l'étoile est utile pour comprendre sa durée de vie. Quels sont donc les moyens pour les calculer, et à quoi cela sert-il réellement concernant le développement de la vie sur une planète ?

Tout d'abord, intéressons-nous au calcul de la masse de certaines étoiles doubles. On distingue plusieurs types de ces étoiles :

- les étoiles dites "visuelles" : il s'agit de celles qui peuvent être observées par des astronomes amateurs, elles sont donc visibles avec de simples télescopes

- les "astrométriques" : elles ne sont pas séparables, mais mesurables par des modifications d'éclat

- les "spectroscopiques" : elle ne sont pas séparables, mais mesurables par des décalages spectraux

- les étoiles dites "à éclipses" : ce sont des cas particuliers d'étoiles qui s'occultent mutuellement

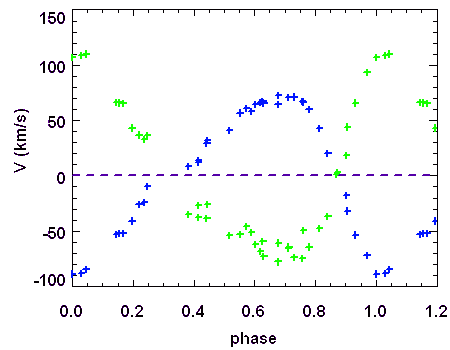

La masse est une des caractéristiques les plus importantes d'une étoile : elle permet en effet de déterminer sa durée de vie, mais également son comportement pendant son évolution, jusqu'à sa "mort". Il existe de nombreux procédés pour calculer cette masse. Certains relient ainsi les différentes caractéristiques de l'étoile (comme la luminosité et la gravité). D'autres encore utilisent la spectrophotométrie. Ne pouvant pas nous intéresser à chacune de ces méthodes, nous allons nous intéresser à l'une d'entre elle en particulier : celle permettant de calculer la masse d'étoiles doubles spectroscopiques. En effet, la majeure partie des étoiles sont des étoiles doubles spectroscopiques : on estime qu'une étoile sur trois en moyenne est une étoile double spectroscopique. Leurs périodes observées s'échelonnent entre quelques heures et quelques années. A l'aide de l'étude de la courbe de vitesse radiale (il s'agit de courbe représentant une période T et une amplitude donnant la composante parallèle "Vr" à la ligne de visée de la vitesse de l'étoile), on peut calculer les différents paramètres qui définissent l'orbite elliptique d'une étoile par rapport à l'autre. Toutefois, il faut savoir que l'on ne connaît (à priori) pas l'orientation du plan orbital dans l'espace, cette détermination se fait à l'effet de projection près.

Courbe de vitesses radiales des 2 composantes de l'étoile double 55 Uma

D'après la définition du centre de masse :

on a la relation, donnée par le rapport des amplitudes des deux courbes :

D'autre part, d'après la troisième loi de Kepler, on a :

Puis on obtient :

Si l'inclinaison

est différente de 90°, l'amplitude de la courbe de vitesse radiale est diminuée d'un facteur

est différente de 90°, l'amplitude de la courbe de vitesse radiale est diminuée d'un facteur

.

.Dans les équations précédentes,

est donc remplacé par

est donc remplacé par  (respectivement

(respectivement  ).

).Nous avons vu que la masse d'une étoile permet de déterminer la durée de vie de cette étoile, en étant lié à la température de cette étoile. On peut ainsi distinguer plusieurs catégories d'étoiles :

- les naines brunes (spectre M, L, T, Y et masse solaire inférieure à 0,08) : elles sont incapables de "s'allumer", c'est-à-dire de démarrer le processus de fusion thermonucléaire faisant la différence entre une étoile et une planète

- les naines rouges (spectre MV et masse solaire entre 0,08 et 0,8) : avec une température en surface de 2 500 et 5 000 K, elles brûlent très lentement leur carburant, s'assurant ainsi une longue existence (la majorité des étoiles de notre galaxie sont des naines rouges)

- les naines jaunes (spectre GV et masse solaire entre 0,8 et 0,2) : les naines jaunes sont des étoiles de "taille moyenne", avec une température de surface d'environ 6000 K. Par exemple, le Soleil est une naine jaune, il s'agit donc de la catégorie d'étoiles la plus susceptible d'entraîner l'apparition de la vie sur les planètes de son système.

- les naines blanches (spectre DA et masse solaire de 1,44) : il s'agit d'étoiles "mortes" n'ayant plus de réaction thermonucléaire de petite taille (environ celle de la terre) qui se refroidissent par rayonnement

- les naines noires (spectre T) : naines blanches ayant perdu tout leur éclat

- les géantes rouges (spectre M et masse solaire supérieure à 1) : il s'agit d'étoiles en fin d'existence, dont le noyau a quasiment épuisé tout son carburant, l'hydrogène

- les géantes bleues (spectre O, B et masse solaire supérieure 18) : ce sont des étoiles très brillantes, très chaudes et très massives, leur température est d'environ 20000 K ou plus, et leur durée de vie est extrêmement courte, entre 10 000 et 100 000 millions d'années, empêchant le développement de toute forme de vie intelligente à proximité

- les supergéantes rouges (spectre MI et masse solaire supérieure à 20) : décrites comme les "grandes sœurs" des géantes rouges dont la durée de vie est minimale.

On peut ainsi en déduire que les étoiles de taille moyenne (ou naines jaunes) comme le Soleil sont les plus favorables à l'apparition de le vie.

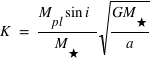

Nous allons maintenant nous intéresser à la masse d'une planète. Cette dernière permet de déterminer la composition de l'atmosphère. Il est cependant plus aisé de calculer la masse d'une planète ayant un satellite en orbite autour d'elle, en considérant ce système comme un "mini système solaire". Prenons ainsi l'exemple de Jupiter, planète géante du système solaire ayant quatre principaux satellites : Io, Europe, Ganymède et Callisto. En supposant que leurs orbites sont à peu près circulaires, on peut calculer la masse de Jupiter à l'aide de la distance "r" entre la planète et son satellite en une période "T".

D'après la formule :

avec :

- M la masse

- r la distance entre la planète et son satellite

- T le temps que le satellite met pour faire le tour de la planète

A l'aide de ces calculs, on obtient, pour Jupiter, M = 1,91 x 1027 kg. En effet, on a pu constater que la distance entre la planète géante et son satellite Europe est de 671 000 km, et que sa période T est de 3,55 jours. Grâce à cette méthode de calcul, on peut atteindre une précision de 0,01% si les mesures sont bien sûr affinées.

De plus, il n'est pas possible d'utiliser cette méthode de calcul lorsque nous sommes confrontés à une planète isolée, c'est-à-dire à une planète sans satellite (comme Mercure ou Vénus)

. Trois solutions sont alors envisageables, solutions que nous ne développeront pas plus, mais qu'il est tout de même bon de citer :

- la première solution est de déterminer la composition chimique de la planète, afin de pouvoir en déduire sa densité. En multipliant le résultat obtenu par sa taille, on peut obtenir une masse approximative, mais cette méthode n'est pas vraiment fiable car certaines propriétés des matières composant une planète sont encore inconnues

- la seconde solution consiste à analyser les petites variations de trajectoires que les planètes exercent entre elles, car ces variations sont directement liées à la masse de la planète

- les troisième et dernière solution reste alors la plus simple : en envoyant un satellite artificiel et en mesurant son orbite autour de la planète, les scientifiques peuvent utiliser la méthode la plus fiable, celle expliquer un peu plus tôt.

La masse de la planète est déterminante pour analyser la composition chimique de l'atmosphère qui l'entoure, car elle est directement liée à la gravité. Cette force sélectionne les atomes retenus sur la planètes et ceux qui peuvent "s'échapper" vers l'espace. Ainsi, si la planète est trop massive, elle retiendra forcément les gaz les plus légers, tels que l'hélium et l'hydrogène, créant ainsi une atmosphère faite de méthane ou d'amoniac (comme sur Jupiter, Saturne, Uranus et Neptune). Au contraire, si la planète s'avère très peu massive, elle laissera s'échapper non seulement l'hydrogène, mais aussi les gaz plus lourds, comme l'oxygène. L'eau s'évaporera également. Des planètes dépourvues d'atmosphère sont exposés à la radioactivité solaire (ultraviolets) et au bombardement des astéroïdes (par exemple, la planète Mercure est dépourvue d'atmosphère). Pour abriter la vie, une planète ne doit donc pas être trop ou trop peu massive.

C) Les caractéristiques chimiques particulières d'une planète

La chimie est une branche de la science qui s'intéresse à la matière. Les caractéristiques chimiques d'une planète sont donc liées aux substances qui composent la matière de la planètes, ainsi que leurs propriétés (transformations de la matière...) : l'atmosphère d'une planète et la présence d'eau à l'état liquide à sa surface, par exemple...

a) Son atmosphère

L'atmosphère d'une planète est un élément essentiel concernant le développement de la vie sur une planète. Nous savons que, dans le système solaire, la Terre est la seule planète à posséder du dioxygène dans son atmosphère. Or, la vie ne pourrait se maintenir sur Terre sans cette épaisse enveloppe de gaz qui entoure la planète. Mais de quoi est composée cette atmosphère ?

L'atmosphère s'étend jusqu'à environ 1 000 km dans l'espace. Elle est évidemment plus dense près de la surface de la Terre, mais s'atténue au fur et à mesure où on s'en éloigne. Cette enveloppe protectrice n'est composée que de gaz, dont les deux principaux sont l'azote, (78%) et l'oxygène (21%), mais on peut également y trouver de l'argon, du dioxyde de carbone et de la vapeur d'eau.

Composition de l'atmosphère

L'atmosphère terrestre est composée de 5 couches :

- la troposphère : la couche la plus proche de la surface terrestre et la plus stable, la troposphère est la zone où se trouve la couche d'ozone. C'est ici que les nuages se forment

- la stratosphère : la seconde couche de l'atmosphère, la température y croît avec l'altitude, notamment grâce à l'absorption du rayonnement solaire par l'ozone (O3)

- la mésosphère : la troisième couche de l'atmosphère, l'air y est plus mince, mais les météores peuvent quand même s'y consumer (d'où les étoiles filantes)

- la thermosphère : la quatrième couche de l'atmosphère, c'est dans la thermosphère que les aurores (polaires par exemple) se forment

- l'exosphère : la cinquième et dernière couche de l'atmosphère, elle marque la limite supérieure. C'est dans cette zone que les vaisseaux spatiaux orbitent.

Schéma de l'atmosphère

L'eau circule entre la surface terrestre et l'atmosphère, assurant ainsi l'approvisionnement constant en eau douce : c'est le cycle de l'eau. Ainsi, les nuages (comme les stratus, les cumulus...) sont fabriqués dans la troposphère par la vapeur d'eau qui s'évapore des cours d'eau (lorsqu'elle est chauffée par le Soleil). Il existe plusieurs types de nuages, comme par exemple les stratus, larges couches d'air tranquille, les cumulus qui moutonnent quand l'air chaud monte, les cumulonimbus, larges et particulièrement hauts, qui apportent la pluie (ou la grêle), et, enfin, les cirrus, au sommet de la troposphère, qui sont constitués d'infimes cristaux de glace.

b) La présence d'eau liquide

La présence d'eau liquide sur Terre est considéré comme le principal atout de la planète concernant l'apparition de la vie à sa surface. Elle contient ainsi une incroyable quantité d'eau : on considère qu'environ 70% de la surface de la Terre est recouverte d'océans ! Mais pour quelle raison est-elle si importante ?

L'eau, avant tout, est une molécule appelée H2O qui peut exister sous trois états bien connus : l'état solide (comme les glaciers), l'état liquide (comme les rivières) et l'état gazeux (comme la vapeur d'eau). L'état sous lequel l'eau se trouve dépend de la température, bien sûr (l'eau se solidifie quand la température est inférieure à 0°C et s'évapore à partir de 100°C), mais aussi de la pression atmosphérique. C'est pour cela que l'eau se trouve sous la forme de neiges éternelles aux sommets de certains glaciers. Afin de savoir se trouverait l'eau, nous allons nous intéresser à un diagramme d'état de l'eau, qui indique les zones de température ET de pression correspondantes à chaque état.

Diagramme de l'eau

Ainsi, sur Terre, les conditions sont telles que l'eau est présente à l'état liquide, avec une température moyenne de 15°C à sa surface et une pression atmosphérique de 101 325 Pa. C'est, actuellement, la seule planète du système solaire possédant ces caractéristiques. La présence d'eau liquide à la surface d'autres planètes par le passé (comme Mar) est une question scientifique majeure.

Les projets des astrophysiciens

Les projets des astrophysiciens

Les astrophysiciens ne cessent de s'interroger sur les projets du futurs qui leur permettraient de faire passer l'exploration spatiale à la vitesse supérieure ! Nous connaissons déjà les satellites artificiels, ces machines créées par l'Homme pour tourner autour d'une planète, comme par exemple les satellites de communication ou encore les sondes spatiales. Le plus ancien objet artificiel de l'espace a été lancé en 1958 : il s'agit de Vanguard 1, alimenté par des panneaux solaires. Les sondes spatiales, quant à elles, sont des engins spatiaux inhabités qui permettent de visiter virtuellement les corps célestes, comme le Soleil et les planètes qui gravitent autour, certaines lunes et même des astéroïdes et des comètes ! Mais, maintenant que nous savons quels ont été les premiers engins envoyés dans l'espace par le passé, pourquoi ne pas nous intéresser aux projets d'avenir des astrophysiciens ?

Nous l'avons vu avec les avancées technologiques : la course aux étoiles est lancée. Sondes du futurs, télescopes super-performants, vaisseaux spatiaux...Tout ceci est consigné dans le super-dossier des scientifiques concernant l'avenir de l'Univers...Parce qu'après tout, pourquoi ne pas voir vraiment grand avec des engins ultra-perfectionnés qui nous permettraient un jour de visiter les planètes de notre Système solaire, mais aussi les systèmes planétaires se trouvant dans le reste de notre galaxie ! Tout d'abord, nous donnerons une définition de la colonisation martienne dans une fiche détailles, puis nous nous intéresserons aux sondes et télescopes appartenant aux futurs projets des scientifiques, avant de découvrir les bolides spatiaux de l'avenir et les énergies qu'ils utilisent.

A) FICHE TECHNIQUE : Qu'est-ce que la colonisation de Mars ?

La terraformation de Mars comporte plusieurs étapes à sa réalisation :

- L'état des lieux : Il est très important de connaitre le territoire que l'on souhaite s'approprier nous devons donc établir la situation de la planète...Ainsi, l'atmosphère de Mars a un climat allant de -140°C à 0°C l'hiver à 20°C l'été, sa pression est inférieure à 1% de la valeur terrestre, elle est constituée de gaz carbonique à 95%, d’azote, d’argon et d’oxygène et autres gaz, l'eau est à l'état de vapeur, de nuages de glace ou du brouillard, et elle est animée de fortes tempêtes pouvant durer plusieurs mois. Parmi les vestiges du passé, on a : des volcans éteints, des cratères, des canyons et des lits de rivières asséchés. Ces diverses formations sont chacune regroupées dans un hémisphère donné.

- La modification de l'atmosphère : Mars a une atmosphère bien trop fine pour être propice à la vie, c'est là la mission principale de la terraformation. Les théories plus reconnues sont de : reformer une atmosphère dense, en important de l’eau, ce qui faciliterait les modifications atmosphériques grâce à leurs réactions. L’eau est également primordiale à la vie, le processus inverse est donc envisageable également, importer du méthane ce qui aiderait à établir un effet de serre pour l’atmosphère et permettrait d’augmenter la pression atmosphérique. De plus, ce gaz peut être utilisé pour produire du dioxyde de carbone et de l’eau : CH4 + 4 Fe2O3 ⇒ CO2 + 2 H2O + 8 FeO. La réaction pourra être produite par la chaleur des rayons solaires sur Mars. Le réchauffement climatique est important pour que des vies puissent s’installer sur la planète. Augmenter l’effet de serre est une bonne solution, mais cela implique une atmosphère suffisamment dense, cela se ferait alors après la reconstruction de l’atmosphère. D’après Robert Zubrin, le président de la Mars Society, il suffirait d’une augmentation rapide de 4°C pour lancer le processus de réchauffement qui se prolongerait de lui-même.

- Les limites du projet : Bien évidemment, ce projet à ses limites : la technologie n'est, pour le moment, pas assez évoluée, la masse de la planète Mars et son attraction gravitationnelle sont plus faible que celles de la Terre, car elle est aussi plus petite, les gaz qui sont censés être recréés pourraient ne pas constituer l'atmosphère martienne du fait de la pression qui est trop faible, le champ magnétique, depuis le deuxième bombardement de comètes sur la planète, a disparu, il n'y a donc pas de protection contre les rayonnements et vents solaires, et, enfin, le dernier grand problème relève de l'éthique, certains scientifique trouvent absurde ou immorale cette idée de terraformer Mars.

B) Des sondes et des télescopes de plus en plus performants

La plupart des découvertes spatiales on eu lieu grâce à ces merveilles technologiques que sont ces sondes et ces télescopes, ceux-ci ne cessent d'évoluer depuis un bon nombre d'années...

a) Le télescope James-Webb, successeur d'Hubble

Très attendu, le télescope spatial James-Webb est considéré par certains comme le successeur de Hubble. Ayant été mis à l’épreuve, il a récemment complété avec succès les tests préliminaires, avant son lancement définitif.

Le télescope James-Webb passait il y a quelques jours avec succès les tests de vide cryogénique qui ont au total duré plus de 100 jours, consolidant ainsi les capacités et le potentiel de l’instrument. Lors d’une conférence de presse tenue le 10 janvier 2018 par la NASA, les responsables du Johnson Space Center à Houston ont notamment évoqué ces essais réussis au sein du « plus grand congélateur spatial au monde », tel que décrit par Mark Voyton. Ces expérimentations ont en effet été menées dans la chambre à vide A du centre, qui a notamment servi à la préparation de la célèbre mission spatiale Apollo. Il s’agit d’une installation d’essai de vide thermique qui « aura permis à l’équipe de tester avec succès l’instrument et ses pièces aux températures extrêmes ressenties dans l’espace ».

Ces tests ont par ailleurs confirmé que tous les miroirs et autres instruments du télescope étaient parfaitement alignés, les 18 segments du miroir primaire fonctionnant tous comme un seul miroir monolithique. Avant de se rendre sur son site de lancement, l’instrument sera prochainement transporté dans un observatoire pour subir des tests environnementaux, c’est suite à ces expérimentations finales que devrait avoir lieu sa mise en service, normalement au début de l’année 2019.

Les capacités du télescope, 100 fois plus puissant que Hubble, surpasseront donc de loin tout ce qui a été créé auparavant. Ce télescope gigantesque, décrit par Voyton comme « la meilleure machine à remonter le temps au monde », a déjà fait preuve de ses capacités en détectant la lumière d’une étoile simulée pour la première fois. Le sous-système de guidage de précision a non seulement réussi à générer la position de la lumière, mais aussi à suivre son mouvement.

S’agissant d’un instrument infrarouge, contrairement à Hubble et sa lumière visuelle, le télescope James-Webb nécessite un environnement extrêmement froid, tel celui ressenti dans la chambre à vide. Une fois en orbite, il pourra alors observer la lumière des premiers instants de l’Univers. Il nous donnera également une vision claire des exoplanètes et de leur atmosphère, révélant probablement des mondes semblables à la Terre, qui pourraient tenir la promesse de soutenir une vie extraterrestre.

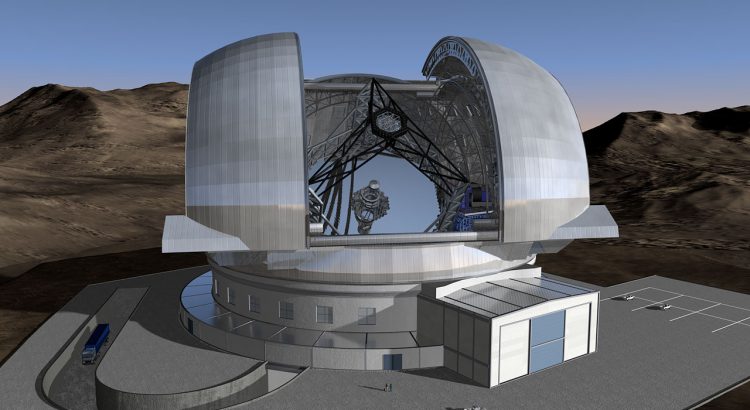

b) "Extremely Large Telescope"...tout est dans le nom

L’astronomie optique (astronomie qui collecte les rayonnements visible et de l’infrarouge proche) est en train d’effectuer un bon fantastique de capacité sur la base de deux technologies nouvelles, l’optique active / adaptative et les miroirs segmentés. En effet ces technologies permettent la construction en cours des ELT (Extremely Large Telescope) qui succèdent ainsi aux grands télescopes des années 1990/2000 du type VLT (Very Large Telescope).

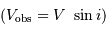

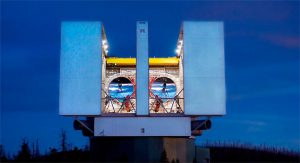

Nous disposons déjà du LBT (Large Binocular Telescope) et allons d’ici à 2025 pouvoir utiliser les TMT (Thirty Meter Telescope), GMT (Giant Magellan Telescope) et E-ELT (European Extremely Large Telescope). Des sources d’énergies spatiales qui nous sont encore inaccessibles (époque de la réionisation de l’Univers, trou noir galactique) de même que les exoplanètes de taille terrestre des systèmes stellaires proches, nous deviendront ainsi « visibles ».

Les quatre ELT ont beaucoup en commun même si la progression se poursuit de l’un à l’autre (les TMT et l’E-ELT étant plus évolués que le LBT et le GMT). Il y a eu un saut par rapport à la génération précédente, car à partir des 8 à 9 mètres de diamètre, les grands miroirs primaires monolithiques butent sur de vrais problèmes de réalisation et d’utilisation. La masse, le volume, les variations thermiques, les déformations dues au poids deviennent extrêmement difficile à gérer. Arrivés à cette constatation, les concepteurs des télescopes Keck mis en service en 1993, avaient déjà démontré les possibilités et les avantages des miroirs minces (de 0,5 à 5 cm d’épaisseur) segmentés (hexagones de moins d’un mètre d’apothème). La substitution de ces miroirs aux lourds miroirs concave monoblocs traditionnels n’était évidemment possible que grâce à l’optique active (pour pallier les déformations dues à la masse même des miroirs) puis adaptative (une multitude d’acteurs agissant extrêmement rapidement pour adapter la surface aux perturbations atmosphériques) que les progrès de l’informatique rendaient possible (et qui se sont accélérés). L’avantage de masse, l’avantage thermique, l’avantage de transport et de manipulation sont énormes. C’est donc cette voie que l’on utilise maintenant d’une façon générale, pour continuer à augmenter la taille des miroirs primaires.

L’instrumentation est semblable dans tous les cas (mais également évolutive vers des capacités de plus en plus remarquables). Il s’agit de caméras extrêmement puissantes, de spectrographes, et d’appareils pour coordonner les ondes collectées, situés sur des plateformes extérieures au tube du télescope. La lumière leur est accessible via un miroir tertiaire mobile de type « Nasmyth » qui renvoie latéralement la lumière (par un orifice ménagé dans la paroi du tube) et qui permet de passer très rapidement de l’un à l’autre du fait de leur disposition sur ces plateformes.

Visualisation de l'E-ELT

Visualisation du LBT

Visualisation du GMT

Visualisation du TMT

C) Les bolides galactiques, des projets de plus en plus fous...

Si un jour on veut visiter les systèmes solaires de notre galaxie, il va nous falloir de vrais bolides spatiaux, qui seront capables d'avaler les milliards de kilomètres nous en séparant...Et ces engins galactiques futuristes, bien que toujours imaginaires, ne sont pas seulement des concepts de la science-fiction...

a) Le vaisseau carburant à l'antimatière

L'antimatière a déjà été nommée "énergie du futur" dans les œuvres de sciences fictions, mais l'idée de fabriquer un vaisseau se propulsant à vitesse incroyable grâce à ce carburant n'en est pas moins scientifique. Au contraire, c'est un projet bien réel, même si, malheureusement, il est quasiment (pour ne pas dire totalement) impossible pour nous, pauvres mortels de notre génération, de voir un jour ce projet se réaliser sous nos yeux...Comment fonctionnerait donc ce vaisseau spatial ?

Tout d'abord, intéressons-nous à ce que représente l'antimatière. Il s'agit bien du "côté obscur de la matière" ! Plus précisément, chaque particule formant nos atomes de matière, comme les protons et les électrons, possède un double d'antimatière, dont les propriétés sont inversées. C'est le même principe que si nous nous regardions dans un miroir : nous représentons la matière, tandis que notre reflet symbolise l'antimatière. C'est pour cela que l'antiparticule de l'électron (dont la charge est environ -1,6.10-31C), est appelée le positon. Il garde la même masse (d'environ 9,1.10-31), mais leur charge électrique est inversée : négative pour l'électron, elle devient positive pour le positon. Normalement, il devrait y avoir autant d'antimatière que de matière dans l'Univers alors, me direz-vous...Après tout, il n'y a aucune raison pour que l'une se soit formée plus que l'autre lors du Big Bang (phénomène marquant l'apparition brutale de l'Univers il y a 13,8 milliards d'années). Or, l'antimatière a quasiment...disparu ! Elle n'apparaît que parmi les résidus de certaines désintégrations de particules, et toujours de manière fugace...Et c'est là un des plus grand mystère de la physique ! Alors, si nous voulons disposer de l'antimatière, il va falloir que nous en fabriquons...

Autant le dire tout de suite : ce ne va pas être de tout repos ! Nous ne sommes pas encore au niveau de Star Trek, avec son fabuleux Enterprise, vaisseau fonctionnant depuis longtemps à l'antimatière, mais nous savons déjà quelles sont les qualités de ce carburant. Avec seulement 20 kg d'antimatière, il est possible d'envoyer une sonde d'une tonne à une vitesse de 130 millions de kilomètres par heure ! Vous imaginez un peu : un voyage jusqu'à Proxima du Centaure ne durerait qu'un peu plus de 40 ans (Proxima du Centaure est l'étoile la plus proche de nous, située à 41 000 milliards de kilomètres...). Mais comment cela est-il possible ? Et bien, grâce à la rentabilité de l'antimatière bien sûr ! Je m'explique : lorsqu'une particule d'antimatière rencontre une particule de matière, elles se convertissent spontanément en énergie dite "pure", grâce à la formule E = Mc2. C'est le même principe que celui de la bombe atomique : un simple gramme d'antimatière suffit à déclencher une explosion semblable à celle qui détruisit la ville d'Hiroshima au Japon, en 1945...

Il est possible de fabriquer l'antimatière dans ce que l'on appelle des collisionneurs de particules, ces appareils qui "cassent" la matière afin d'étudier les composants fondamentaux (un exemple de collisionneur est le LHC, ou Large Hadron Collider, en Suisse). Il est alors inutile de préciser la dangerosité de l'antimatière : une fausse manipulation, et ce n'est pas seulement la Terre, mais tout le Système solaire qui s'éparpillera dans la galaxie à la manière d'un puzzle...Pour que l'engin du futur puisse être fonctionnel, il faudrait donc éviter de le faire démarrer à l'antimatière quand il est encore à la surface de notre planète...C'est pour cela que les physiciens proposent d'envoyer en orbite le vaisseau à bord d'une fusée classique, avant de le laisser fabriquer son carburant à petite dose tout au long du trajet vers Proxima du Centaure...Quitte à choisir entre l'explosion du Système solaire ou un décollage un peu moins spectaculaire, nous imaginons que la réponse est déjà toute trouvée...

Comment faire alors jaillir des antiparticules du vide ? Pour cela, il suffirait de délivrer une puissance de l'ordre de 10-29 watts en un point de l'espace à l'aide de lasers, ces faisceaux lumineux très énergétiques. L'énergie apportées se transforment alors en gerbe de particules et d'antiparticules associées. Un fois l'antimatière produite, pas question de la mettre dans un réservoir ! On va alors la manipuler à distance en l'utilisant comme un propulseur. Il ne nous reste alors qu'à produire assez d'énergie avec des lasers, comme avec Apollon, l'un des plus puissants faisceaux lumineux du monde en cours d'installation en France. Est-ce alors un premier pas vers les étoiles ?

Ainsi, on peut insister sur l'idée que le vaisseau carburant à l'antimatière n'est pas purement fictive : le simple fait que la bombe atomique est un jour vue le jour nous montre que tout n'est pas impossible. Cependant, pour le moment, il est certain que la seule chose astronomique dans l'antimatière n'est pas sa quantité mais...son prix ! 9 000 milliards d'euros environ pour un gramme, on a comme l'impression que le prix du billet sur notre futur Enterprise ne sera pas très bon marché...

Image de synthèse du vaisseau marchant grâce à un

anticarburant : l'Enterprise de Star Trek

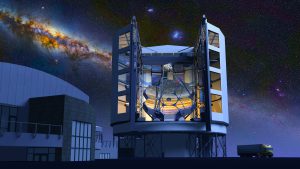

b) La voile solaire

Naviguer à la voile solaire, comme dans La planète aux trésors de Disney, ce n'est peut-être pas une idée si fabuleuse finalement...On a du mal à y croire, et pourtant, les astrophysiciens se penchent sérieusement sur la question. Vous êtes vous déjà imaginé un jour crier depuis le vide intersidérale "Hissez la grande voile ! Cap vers les étoiles !" ? Non ? Nous oui...Comment serait-ce possible ?

La voile solaire permettrait à un vaisseau spatial de voyager à plus de 50% de la vitesse de la lumière (50% de 300 000 km/s, soit 540 millions de km/h)...Et pas la peine d'attendre que le vent se lève (de toute manière, dans l'espace, il n'y en a pas) : il suffira simplement de se servir de la lumière, que l'on nomme alors le "vent" de photons. Pour cela, un photon frappant la voile lui transmettrait sa propre quantité de mouvement, qui correspond à l'énergie du photon divisée par la vitesse de la lumière. Si la voile est noire, le photon disparaît, cédant son énergie et sa quantité de mouvement à la voile qui avance alors. Si, au contraire, la voile est réfléchissante, le photon repart en sens inverse sans céder d'énergie, et avec une quantité de mouvement inverse, un peu comme une balle rebondissant contre un mur...

On peut donc dire que la voile a vu arriver une quantité de mouvement p et a vu repartir une quantité de mouvement -p. On a alors un calcul :

p-(-p) = p +p = 2p

Le fait de réfléchir les photon double donc la quantité de mouvement reçue par la voile, et donc sa vitesse. Voilà pourquoi elle est réfléchissante (de plus, comme elle est incapable de capter de l'énergie, elle ne peut pas brûler).

C'est donc à la manière des molécules d'air heurtant la voile d'un navire que les photons vont communiquer de l'énergie en frappant celle de notre vaisseau. Seule la taille diffère, car les photons n'ont pas de masse, mais de l'énergie que nous devons récupérer pour avancer. Petit problème : cette énergie est infime. Il faudra donc, pour un tel projet que notre futur bateau spatial, une grande quantité de photons et des voiles de grande taille.

La première idée pour mener à bien le projet serait de se servir de l'énergie produite par le Soleil, qui nous permettrait alors d'explorer le Système solaire tranquillement, grâce à ses photons fiables et gratuits. Cependant, ce ne serait pas suffisant pour quitter notre système, car la lumière commence à se raréfier après que nous ayons passé Jupiter. C'est pour cela que les chercheurs ont émis l'hypothèse d'utiliser un laser pour gonfler la voile. Bien que moins puissant que le Soleil, son rayonnement lumineux sera moins dispersé et se concentrera sur un seul point. Il faudra alors mettre notre énorme laser en orbite autour de la Terre avant de pouvoir gonfler la voile...Sauf que ce laser ne s'alimentera pas tout seul ! Pour lui fournir l'énergie dont il a besoin, il lui faudrait être alimenté par plusieurs centrales nucléaires. De plus, malgré l'immensité de la voile (des centaines de kilomètres carrés), la précision du laser n'est pas à négliger : il sera très difficile de viser notre vaisseau à plus de 4,3 années-lumières.

Ainsi, en 2010, l'agence spatiale japonaise, la Jaxa, a déployé dans l'espace une voile de 200m2 faite en résine ultrafine, réfléchissante et légère (elle pèse seulement 15 kg) nommée Ikaros. L'agence voulait alors montrer que la voile pouvait être propulsée par les photons solaires...Et ça a marché ! Elle a subi une pression équivalente à celle exercée par un objet d'un dixième de gramme. Depuis, évidemment, la voile solaire a "le vent en poupe". Cette année 2018, nous savons que la Nasa envisage d'expédier un minisatellite à l'aide d'une voile vers un astéroïde. Quant au milliardaire Iouri Milner, il a mis 100 millions d'euros dans la création de la première sonde capable, dans 20 ans, d'aller sur Proxima du Centaure à l'aide d'une voile propulsée au laser. Nous avons déjà vu le principe de la miniaturisation des engins spatiaux...La prochaine étape, lorsque nous serons parvenus à expédier des sondes spatiales vers d'autres systèmes solaires, sera d'y envoyer des êtres humains...

Image de synthèse de la future voile solaire

En conclusion, la voile solaire est une idée fortement appréciée par les astrophysiciens, notamment parce que, contrairement, par exemple, au vaisseau carburant à l'antimatière, son carburant n'est pas totalement inconnu. Peut-être voyagerons-nous un jour à bord d'un vaisseau volant vers d'autres cieux, à la manière du Capitaine Crochet dans Peter Pan. Mais pour le moment, nous nous contenterons d'observer les étoiles à travers des télescopes toujours plus performants, rêvant d'aventure sur les ponts de l'USS Enterprise...

Les méthodes d'observations et les motivations

Les Méthodes d'observation et les motivations

Les scientifiques actuels utilisent de nombreuses méthodes afin de détecter les exoplanètes, des méthodes qui, au fil du temps, se sont améliorer encore et jours grâce à de nombreuses évolutions. Comment ces chercheur parviennent-ils donc à déterminer la masse, la taille ou tout simplement la présence d'exoplanètes à des centaines d'années-lumière de la Terre ?

Et bien ils y arrivent par le biais de moyens divers et variés. Pour répondre à la question posées précédemment, nous étudierons dans une fiche technique détaillée les méthodes de détection grâce aux vitesses radiales. Ensuite, nous étudierons les méthodes principales de recherches d'exoplanètes. Enfin, nous terminerons par l'analyse des méthodes de détection des exoplanètes.

A) FICHE TECHNIQUE : Qu'est-ce que la méthode de la vitesse radiale ?

La méthode de la vitesse radiale s’appuie sur les perturbations qu’une planète provoque sur le mouvement de son étoile.

51 Pegasi b avait été détectée par vélocimétrie, méthode qui consiste à mesurer les variations de vitesse radiale de l'étoile dues à la planète, et qui ne fournit qu'une masse minimale pour celle-ci. En effet, tout comme l’étoile exerce une force d’attraction gravitationnelle sur la planète, cette dernière produit une force égale et opposée sur l’étoile, bien évidemment, l’étoile est beaucoup plus massive que la planète et l’effet de cette force réciproque est donc extrêmement faible. Les variations de position de l’étoile sous l’effet de cette perturbation planétaire sont très faibles et trop difficiles à détecter à l’heure actuelle.

La méthode de la vitesse radiale cherche donc à mesurer de petits changements de vitesse plutôt que de position de l’étoile. Un moyen très efficace pour cela est d’utiliser l’effet Doppler*. En effet, les variations de vitesse de l’étoile le long de notre ligne de visée se traduisent, grâce à l’effet Doppler, par de légers déplacements en longueur d’onde du spectre apparent de l’étoile.

Il suffit donc en théorie d’identifier certaines raies de ce spectre et d’observer les faibles changements de leur longueur d’onde avec le temps pour en déduire la présence d’une perturbation gravitationnelle par d'autres corps.

Evidemment, ces fluctuations sont toujours très faibles et ne sont généralement détectables que lorsque la planète produit d’importantes perturbations gravitationnelles.

Ceci limite la méthode de la vitesse radiale aux planètes massives de type géante gazeuse, et uniquement si ces planètes sont plus proches de leur étoile que Mercure de notre Soleil. Lorsque ces conditions sont réunies, des observations spectroscopiques très précises peuvent révéler la planète et fournir approximativement sa masse et des informations sur son orbite.

Graphique de la vitesse radiale de l'étoile 51 Pegasi (1995)

Principe de la méthode

Effet Doppler sur la lumière provenant d'une étoile perturbée par une planète. La lumière est décalée vers le bleu (courtes longueurs d'onde) lorsque l'étoile se rapproche de nous, et vers le rouge quand elle s'éloigne. La courbe en haut à droite donne la courbe de vitesse radiale de l'étoile que l'on peut déduire de son décalage Doppler.

Quand l'étoile a un mouvement qui la fait se rapprocher de nous, sa lumière est décalée vers le bleu, alors qu'elle est décalée vers le rouge quand elle s'éloigne.

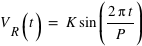

L'amplitude de ces décalages est proportionnelle à la vitesse de l'étoile. Dans le cas simplifié où l'orbite de l'étoile (due à une planète) est parfaitement circulaire, la vitesse VR à laquelle elle s'éloigne ou se rapproche de nous varie en fonction du temps suivant :

avec :

- K est l'amplitude de la variation de

, donnée par :

, donnée par :

- i est l'angle entre la ligne de visée de l'observateur et la perpendiculaire au plan de l'orbite de la planète.

L'effet Doppler est maximum quand cet angle est égal à 90°, c'est-à-dire quand on regarde l'orbite "par la tranche". Quand i est nul, la vitesse de l'étoile n'a pas de composante radiale. Dans ce cas, même si une planète est présente, cette méthode ne permet pas de la détecter. L'amplitude de l'effet Doppler induit par le mouvement de l'étoile est de l'ordre de K/c, où c est la vitesse de la lumière, c'est-à-dire de quelques m/s (la vitesse d'un homme qui court) divisés par 300 000 km/s. Il s'agit donc de mesurer des effets extrêmement fins. A l'heure actuelle, on peut détecter des vitesses radiales de l'ordre de ∼0.5m/s : cela signifie qu'une "Exoterre" est presque à notre portée.

B) Les méthodes de recherche des exoplanètes

a) La méthode de l'observation directe

La première méthode de recherche dont nous allons parler est l'observation directe : elle se fait par l'expédient d'un télescope ayant une résolution suffisamment puissante pour distinguer deux astres en orbite l'un autour de l'autre. C'est d'ailleurs la raison pour laquelle on développe des télescopes d'une résolution de plus en plus grande avec des techniques d'optique adaptative.

Prenons pour exemple le E-ELT, pour European Extremely Large Telescope, télescope terrestre, faisant partie de la série des trois télescopes géants en cours de construction, qui doit être inauguré en . Il sera situé au nord du Chili, sur le Cerro Armazones (3 060 mètres d'altitude). Construit par l'Observatoire Européen Austral (ESO), il doit permettre des avancées majeures dans le domaine de l'astronomie grâce à son miroir primaire d'un diamètre de 39 mètres.